近年、建設業界でデータセンター(DC)案件が”儲かる”と言われるのは、単に市場が伸びているからだけではありません。

DCは「箱」をつくる仕事ではなく、電力・空調・通信・冗長・運用を一体で成立させる”インフラ装置”だからです。

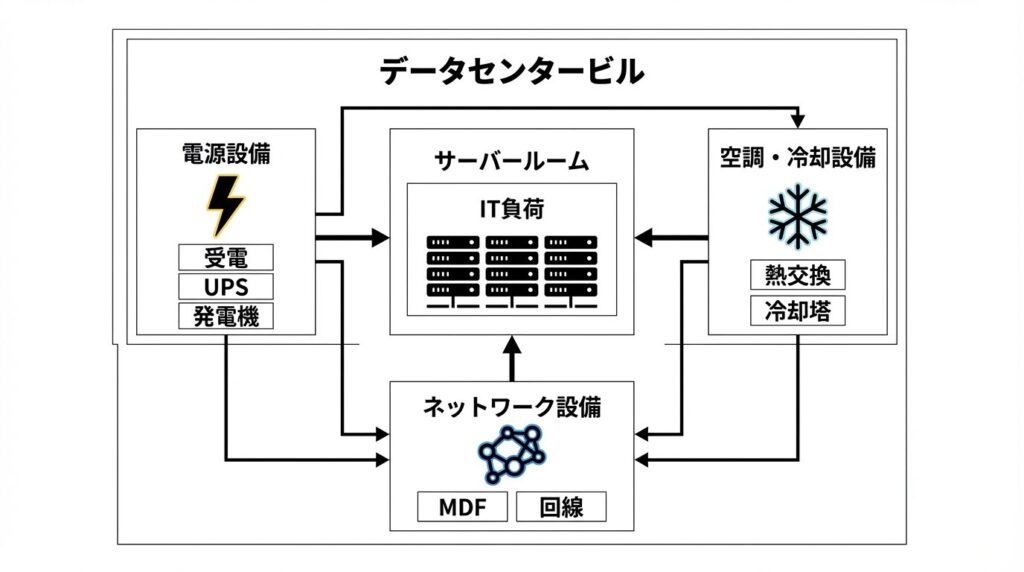

DCは下記の模式図に表すように、”建物”というより”インフラ装置”です。

データセンターを構成する3大要素:電力(受電・UPS・発電機)、空調(熱交換・冷却塔)、ネットワーク(MDF・回線)が中央のサーバールーム(IT負荷)を支えていることがわかる模式図

そして、

生成AIの波で、DCは

「CPU中心の時代から、GPU中心の時代へ」と次のフェーズへ入りました。

その結果、発熱密度・電力密度・冷却方式・立地条件・CAPEX更新計画まで、前提がごっそり変わっています。

この記事では、社内勉強会で整理された”現場の実務論点”をベースに、

「なぜDCは高付加価値になるのか。どこが難しく。どこで差がつくのか。」

を、設備・建築技術者向けに噛み砕いて解説します。

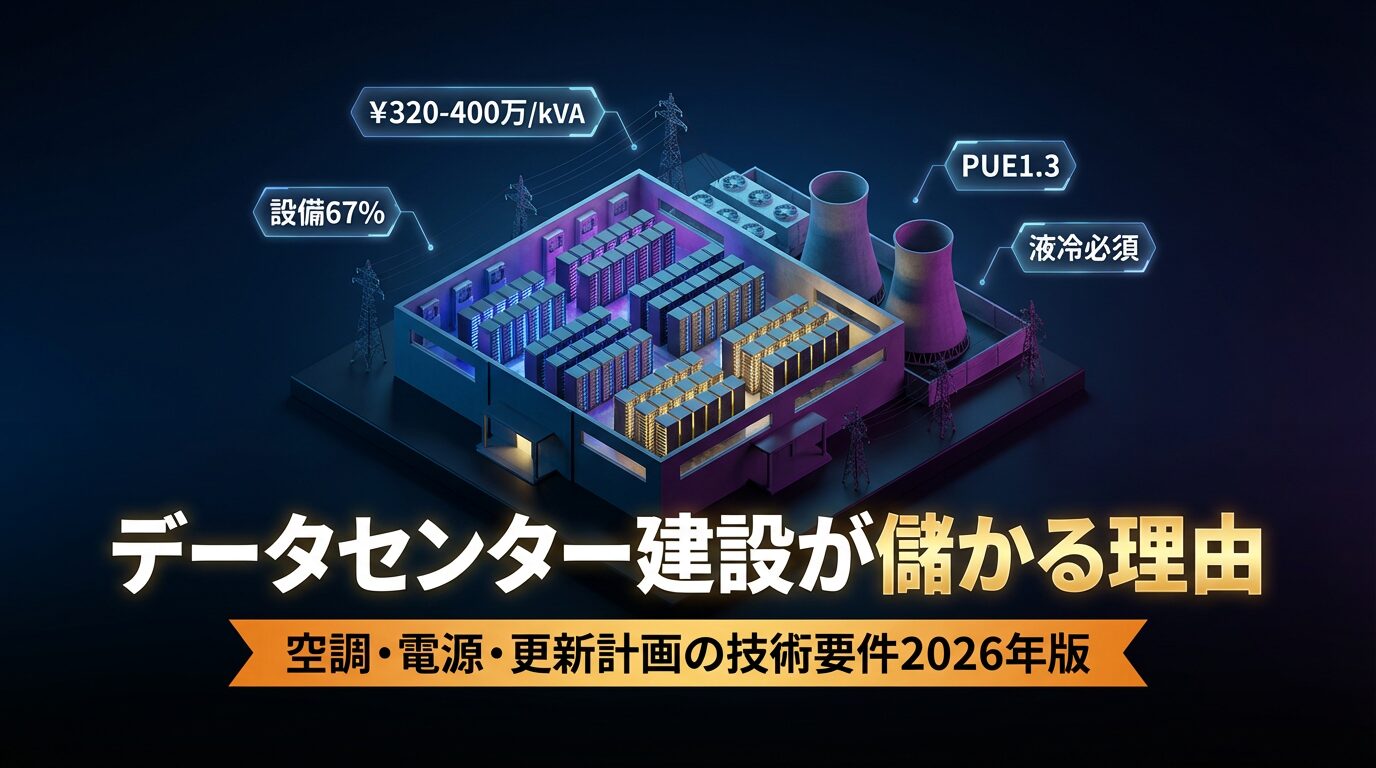

DCが”儲かる”のは、設備が主役の「巨大な精密機械」だから

DCの建設費構成は、一般建築と逆転しており、設備比率が極端に大きいです。

つまり、設計・施工・調達・試運転・運用設計の全てにおいて、設備の出来が価値を決めます。

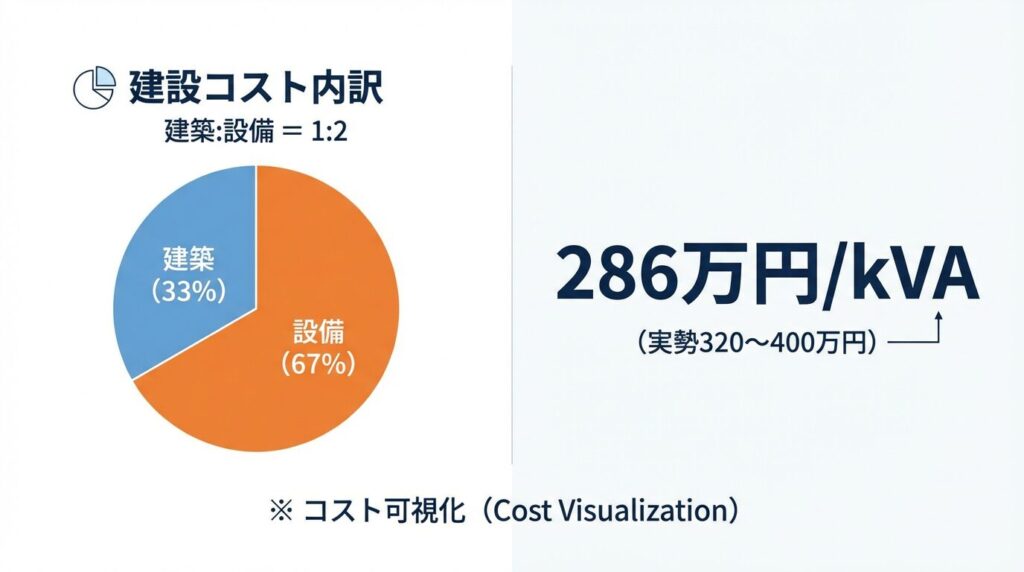

建設費の内訳とkVA単価

DCの建設コストの比率は、建築:設備=1:2です。

ITロードあたり286万円/kVA(実勢では320〜400万円/kVA)という高単価が設備主導の証です。

しかも、今は建設費が高騰しており、ITロード(kVA)あたりの単価も上がっています。

ここで重要なのは、単価が上がること自体ではありません。

“止めない設計”と”更新できる設計”を成立させられるチームに、仕事が集まることです。

DCは「竣工=完成」ではありません。

稼働しながら増設し。稼働しながら更新し。契約と運用で”止めない”ことまで含めて、初めて完成します。

この難易度が、そのまま付加価値になります。

まず押さえる。DCのタイプで「設計の前提」が全て変わる

DCは一括りにされがちですが、実務では最初に”型”を決めないと破綻します。

大きくは次の整理が有効です。

- キャンパス型: 複数棟が集積する施設

- 単独DC型: 単独敷地内で成立させる施設

- エッジ型: 拠点近傍に分散配置する施設

に大別できます。

さらに単独DCの中でも、ターゲットで別物になります。

- エンタープライズ向け(企業システム)

- ハイパースケール向け(クラウド)

- 生成AI向け(学習/推論)

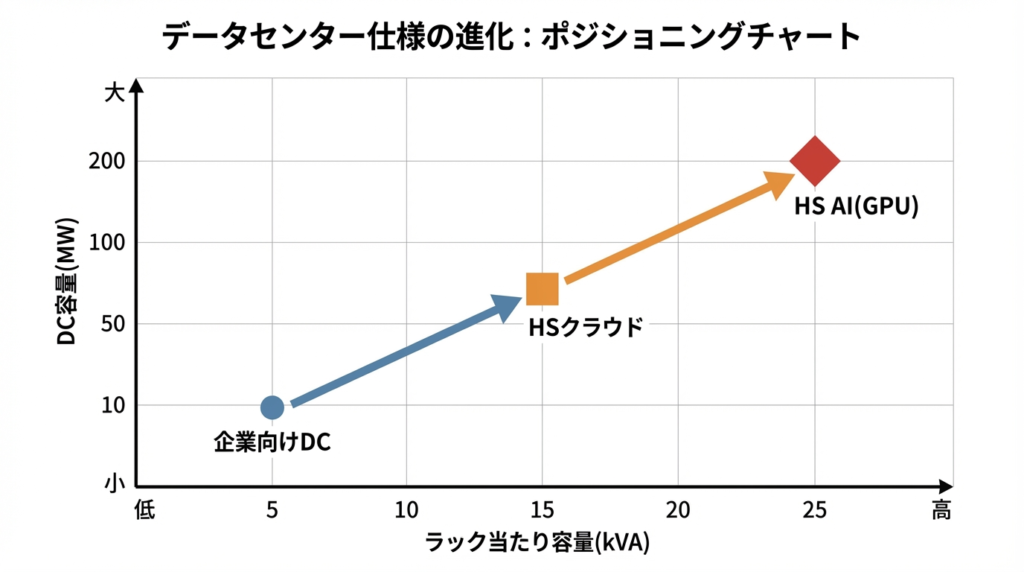

上記がデーターセンターのターゲットによるポジションチャートです。

企業向けDC→HSクラウド→HS AI(GPU)へと、ラック当たり容量・DC容量ともに右上へ進化します。

時代とともに求められるスペックは高度化しており、時代はCPUからGPUへと変化してきています。

ここが重要なポイントですが

「どの型のDCとするか」で「立地条件も。電力容量も。求められる冷却も。契約も。運用も。」全部が変わります。

そのため、案件初期でやるべきは

敷地条件から”どの型のDCか”を確定し。その型に合わせて事業計画と設計条件を固定する。

この初動が、勝負の8割と言ってもよいでしょう。

空調が激変。AI時代は「空冷の延長」では追いつかない

CPU時代の空調は”空気を運ぶ”が主戦場だった

従来のDCは、空冷が主流でした。

冷水をつくり。空調機で冷風を送り。ホットアイル/コールドアイルで気流を管理する。

これがこれまでの世界観です。

この時代は、

「気流の整流」

「ダクト・床下・天井裏の圧損」

「外気冷房」

などが省エネと性能を左右しました。

GPU時代は”熱交換そのもの”が主戦場になった

生成AIでは、GPUの進化で発熱密度が跳ね上があがりますが、空冷では物理的に限界があります。

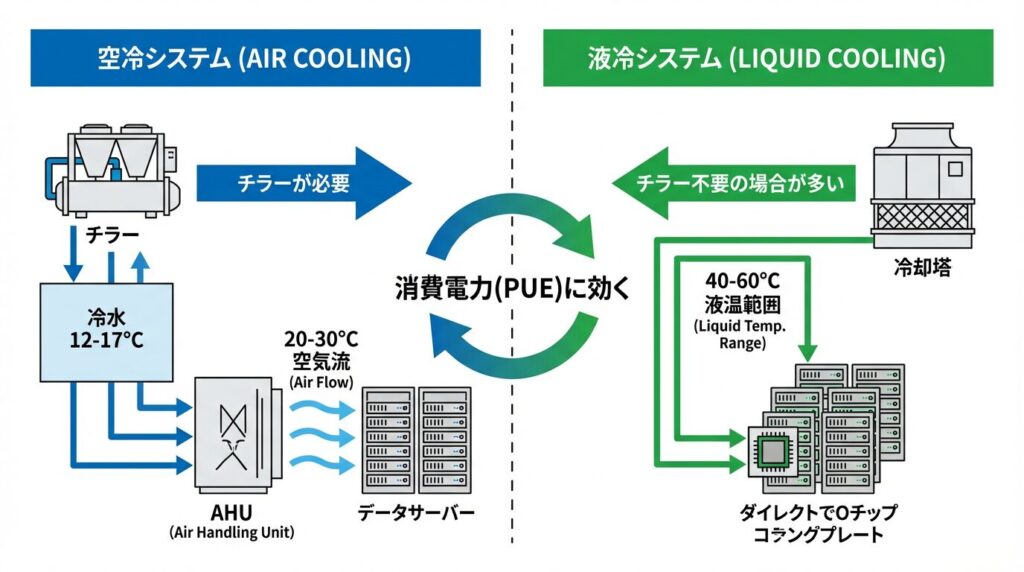

空冷から液冷へとシフトしている理由は、

空冷では冷水12〜17℃とするためにチラー必須となります。

一方、液冷は40〜60℃で運用可能で、チラー不要の場合も出てきます。

そのため、PUE改善に直結します。

ここで登場するのが、液冷(DLCなど)です。

AI向けDCでは、

「空気を冷やす」から「熱を液体で回収する」へ

が設計思想へとシフトしています。

液冷が入ると、設計の論点がこれまでのものから変わります。

- 冷却水の温度帯が変わる

- チラー依存を減らせる可能性がある

- PUEを1.05〜1.1に近づける余地が出る

- ただし配管・漏水・保守・冗長の難易度が上がる

そして現実は、さらにややこしいです。

GPUは液冷でも、ネットワーク機器などは空冷が残るということです。

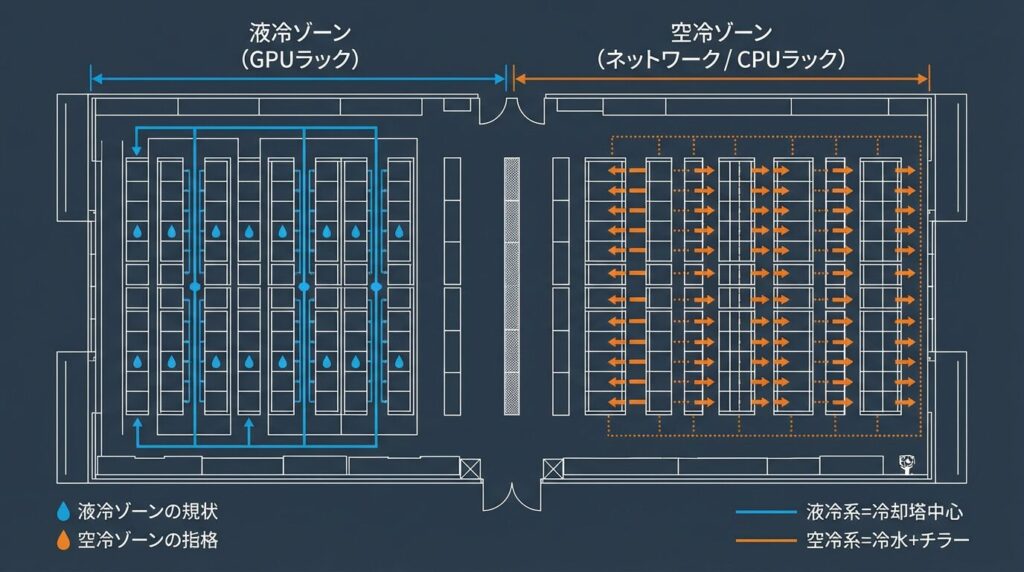

つまり、下記のように、空冷+液冷のハイブリッドになりやすいということになります。

サーバー室内にGPUラック(液冷)とNW/CPUラック(空冷)が混在。空冷系=冷水+チラー、液冷系=冷却塔中心の二系統運用

PUEが”設計指標”から”競争力”に変わった

DCの省エネ指標として、今や避けて通れないのがPUEです。

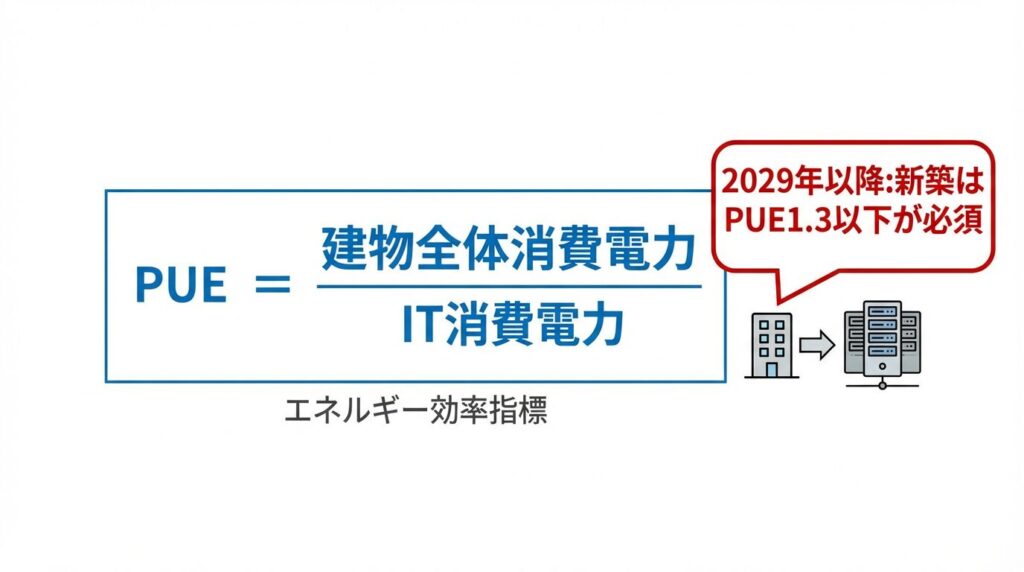

PUE=建物全体消費電力÷IT消費電力。2029年以降の新築DCはPUE1.3以下が必須に

PUEは、

建物全体の消費電力 ÷ IT機器の消費電力

で表されます。

1に近いほど効率が良いということになります。

ここで重要なのは、PUEが単なる環境指標ではないということです。

ユーザーの電気代に直結し。ユーザーがどのDCを選ぶかに直結し。結果として賃料・稼働・競争力に直結します。

つまり、ユーザーが求める「価値」そのものです。

さらに現場では、ありがちな落とし穴があります。

設計時は良さそうでも、運用を開始すると思った通りになっておらず

「設計は1.4。実運用は1.6〜1.8。」

このギャップが普通に起きてしまいます。

そのため、設計者は、図面を引いて終わりではなく、

“運用で崩れない設計”まで責任を持つことが価値になります。

今後はこういった観点を「売り」にしてくる設計者も増えてくることでしょう。

冗長(N+1・2N)は”設計”だけでなく”更新計画”で決まる

DCで最も嫌われる言葉は、停止です。

そのため、冗長構成は当たり前です。

ただし本当の難しさは、そこではありません。

難しいのは、設備更新を止めずにやることです。

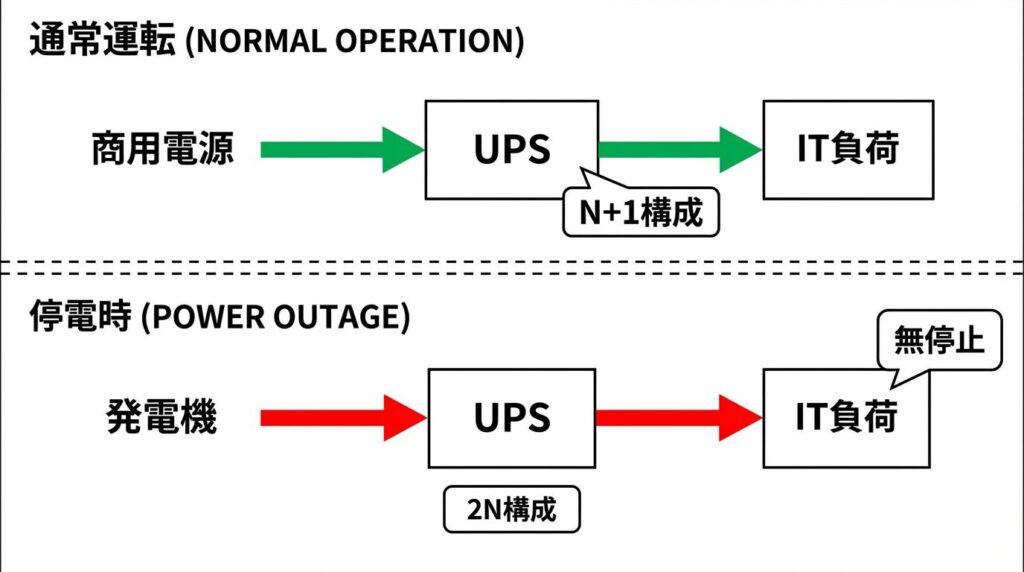

平常時は商用電源→UPS→IT負荷として、停電時は発電機起動→UPS経由で無停止継続する。

N+1、2Nの冗長構成が前提とするのが常識です。

DCは長寿命のアセットとして設計されます。

そして実務上、15年程度で大きな更新が来ることを前提に動きます。

しかし、空調も。受変電も。UPSも。蓄電池も。

稼働したまま入れ替えが難しい。

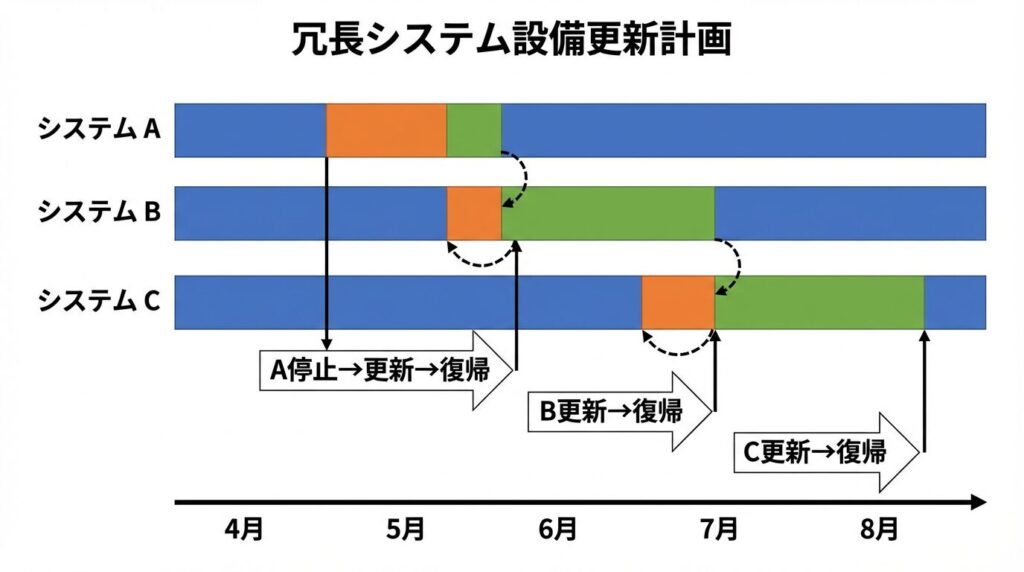

例えば、下記のような方法を予め計画しておく必要があるわけです。

3系統(A/B/C)で、A停止→更新→復帰→B更新…と順次更新。止めない更新計画が設計段階から必須

そのため、新築段階で、次の思想が必要になります。

- 更改スペースを確保する

- バイパスや段階切替を組み込む

- 更新時に一時的に冗長が崩れることを契約に織り込む

- 実使用が契約より小さい”余力”を更新バッファとして使えるように運用設計する

「冗長がある」だけでは不十分です。

“更新できる冗長”になっているか。

ここがプロの評価軸です。

非常用発電は「どこまで守るか」を設計者が言語化する

非常用発電は、とにかく積めば良いわけではありません。

敷地。燃料タンク。補給契約。運用体制。

全てが絡むからです。

実務の考え方としては、こう整理すると伝わります。

- ITロードは守る

- それに付随する空調は守る

- 照明などは”守らない”判断もあり得る

燃料は、目安として72時間が一つの基準になりやすいです。

ただし都市型はタンク容量がネックになるため、

2日分+優先供給契約で補うような設計・契約が現実解になることも多いです。

この「割り切り」を、要求性能と費用対効果の言葉で説明できる人が強いです。

立地の勝負は”電力”と”低遅延”で二極化する

生成AIで立地戦略は二極化します。

おおまかには、学習=郊外/推論=都心と理解しておくと良いでしょう。

左:郊外・地方(学習=Training)は大電力・低コスト重視で低遅延不要。右:都心(推論=Inference)は低遅延必須でIX近接が競争力

学習(トレーニング)用途:郊外・地方が有利

低遅延が必須ではないです。

とにかく安く。大量の電力が欲しい。広い敷地が欲しい。というのがユーザーの要望です。

再エネ近接なども含め、地方が合理的になります。

推論用途:都市近傍が有利

低遅延が価値そのもの。

距離が伸びるほど応答が遅れ、サービス品質が落ちます。

そのため、IXやネットワーク接続点への近さが重要です。

つまり、DCの立地はこう言い換えられます。

「電力に寄るか。遅延に寄るか。」

この二択を、案件初期に決め切れるかが重要です。

工程は長い。だから”フロントローディング”が利益を守る

DCは工程が長期化しやすいです。

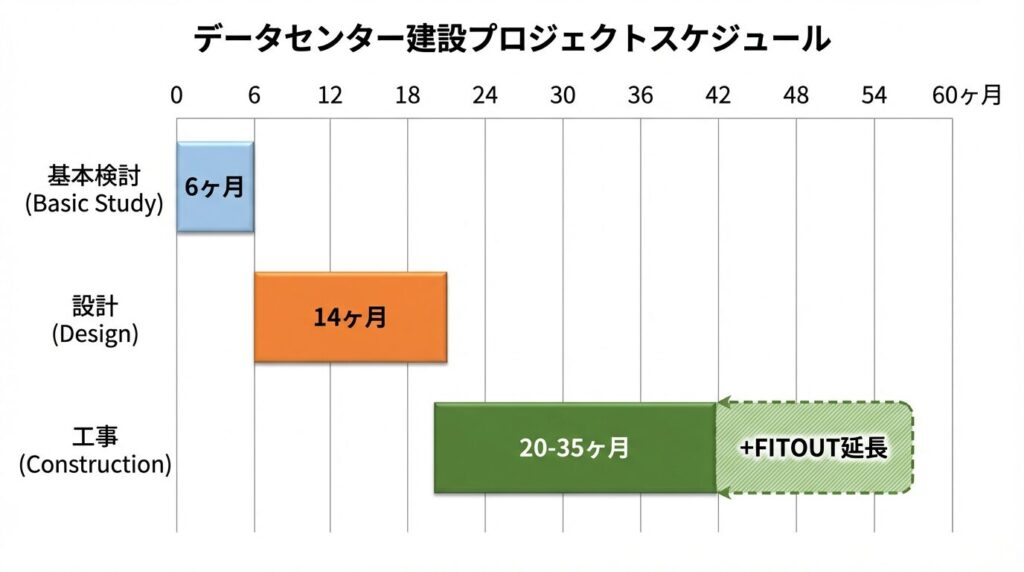

おおまかな工期は下記のように考えておきましょう。

設計だけで一年級。

建設で二〜三年級。

さらに竣工後も増設工事が続くことがあります。

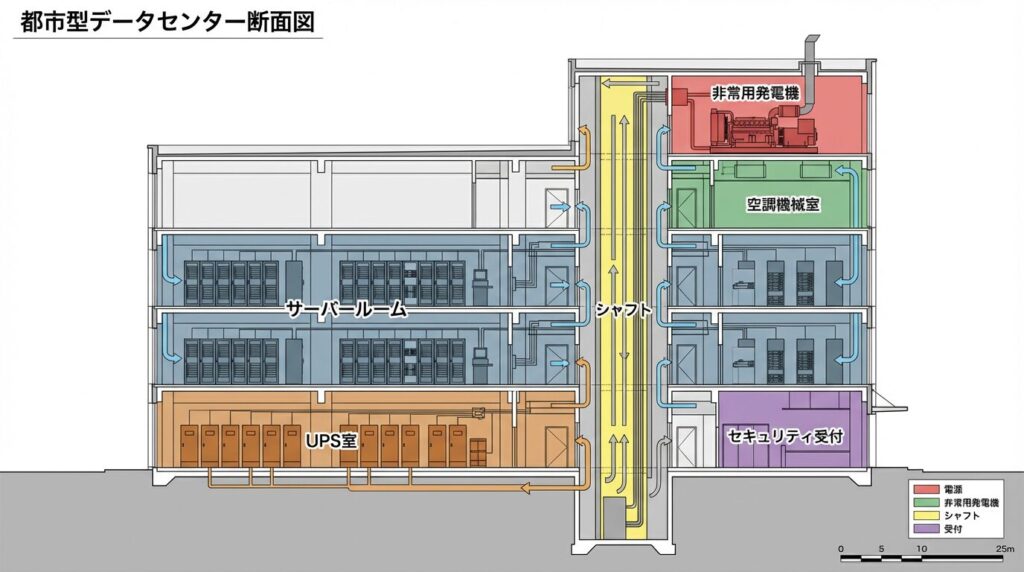

また、建物の大まかな断面構成を下記示します。

サーバールーム、UPS室、シャフト、屋上の非常用発電機など、設備比率の大きさと諸室の多さが一目瞭然だと思います。

この世界で一番コストを壊すのは、現場の手戻りです。

そのため、DCは、最初からフロントローディングが必須になります。

- 干渉が起きる前に潰す

- 冗長ルートを先に確定する

- 試運転と切替手順を先に設計する

- 運用チームの要求を設計に織り込む

“図面の完成度”ではなく、”止めないための手順の完成度”が利益を守ります。

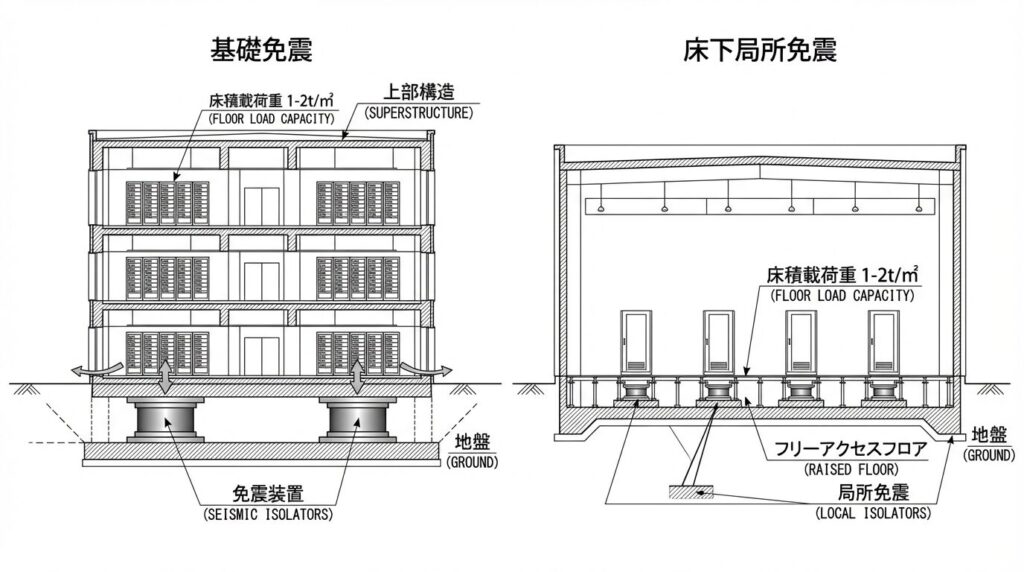

法規・構造で見逃せない論点:免震がマストになる理由

DCは一般建築に比べて、構造・法規面でも特殊な要求があります。

DCでは免震がほぼマストと考えてもよいでしょう。

サーバーラックやネットワーク機器は振動に弱く、地震時の稼働継続が求められるため、免震構造が事実上必須になります。

また、床荷重も一般建築の数倍(1〜2トン/㎡)が必要です。

この構造要件が、建設コストを押し上げる大きな要因の一つになっています。

結論。DCで稼ぐ人が持っているのは「設備の知識」ではなく「止めない設計の型」

DCが儲かるのは、「難しいから」です。

そして難しさの正体は、

空調方式が変わる。

電力が巨大化する。

冗長が必須になる。

更新が前提になる。

低遅延が価値になる。

という、前提の総入れ替えにあります。

そのため、これからDC領域で価値を出す人はこうなります。

- DCタイプを初期に確定できる

- PUEを”運用まで含めて”設計できる

- 液冷/ハイブリッドの落とし所を提案できる

- 設備更新を止めずに回す設計と契約条件を言語化できる

- 非常用発電の守る範囲を説明できる

- 学習/推論で立地の勝負軸を変えられる

DCは、建築と設備の総合格闘技です。

そして生成AIで、その難易度はさらに上がりました。

この波に乗れる設計者・施工者は、間違いなく市場で評価されます。

おまけ。建築技術者が明日から使える「DC初期検討チェックリスト」

- ターゲットは。エンタープライズか。ハイパースケールか。生成AIか(学習/推論)。

- 必要ITロード(MW/kVA)は。受電方式と冗長は。

- 冷却方式は。空冷か。液冷か。ハイブリッドか。

- PUE目標は。設計だけでなく運用で守れるか。

- 災害ハザードは。主要設備の上階配置が必要か。

- 非常用発電は。守る範囲は。燃料は。補給契約は。

- CAPEX更新は。15年後に止めずに更新できるか。更改スペースはあるか。

- 推論なら。IX/接続点までの距離は。低遅延要件は。

コメント